Modellinformationen

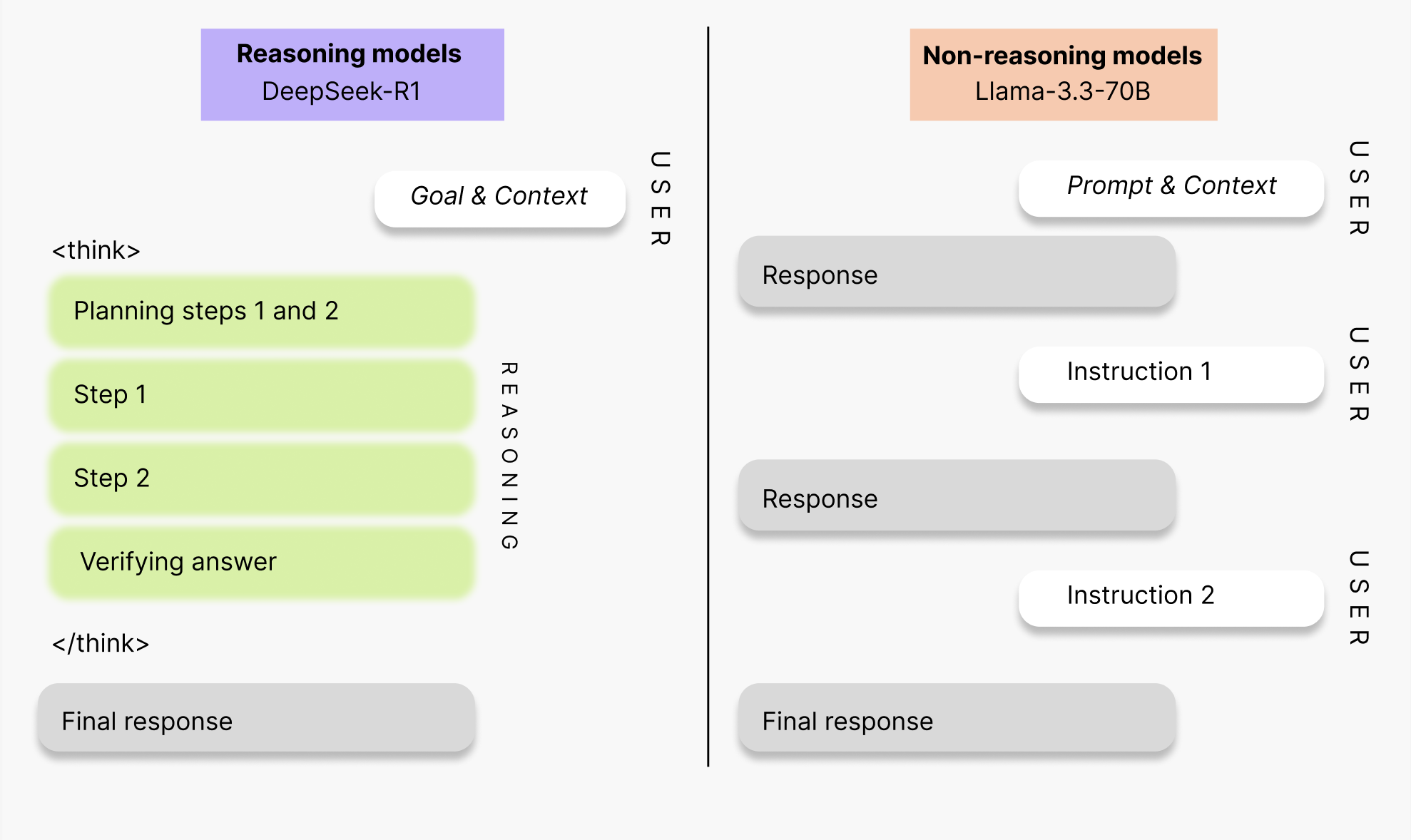

DeepSeek R1 ist ein Open-Source-Reasoning-Modell mit 671 Milliarden Parametern. Es verwendet Tokens speziell zum Nachdenken darüber, wie auf den Benutzer-Prompt reagiert werden soll, die innerhalb der<think>-Tags in einem Output angezeigt werden. Aufgrund dieser strukturellen Unterschiede zu typischen Modellanfragen sollten Sie die folgenden Anpassungen berücksichtigen.

System-Prompt

- Entfernen Sie instruktionale System-Prompts und minimieren Sie zusätzliches Prompting über die Benutzeranfrage hinaus. Übermäßige Anweisungen können den Reasoning-Umfang des Modells einschränken und die Output-Qualität reduzieren.

Benutzer-Prompt

- Vermeiden Sie zusätzliches Chain-of-Thought-Prompting und explizite Anweisungen, wie zu reagieren ist, da das Modell Anfragen bereits in seinem Denkansatz verarbeitet. Es ist am besten, Zero-Shot- oder Single-Instruction-Prompts in einfacher Sprache für komplexe Aufgaben zu verwenden. Dieser Ansatz ermöglicht es den internen Reasoning-Fähigkeiten des Modells zu glänzen.

- Experimentieren Sie mit der Struktur dieser Abschnitte: Ziel, Rückgabeformat, Warnungen und Kontextdump.

- In dem seltenen Fall, dass die

<think>-Tags umgangen werden, können Sie deren Verwendung erzwingen, indem Sie dem Modell mitteilen, mit<think>-Tags zu beginnen. - Um prägnantes Denken zu erzeugen, kann die Idee des Chain-of-Draft verwendet werden, also beispielsweise das Hinzufügen von “behalte nur einen minimalen Entwurf für jeden Denkschritt, mit maximal 5 Wörtern” als Einschränkung in Ihrem Prompt.

Parameter

- Für allgemeines Reasoning (Nicht-Mathematik-Reasoning) wird

temperature= 0,6 undtop-p= 0,95 empfohlen. Wenn Sie eine faktischere Antwort bevorzugen, kanntemperatureauf einen kleineren Wert gesetzt werden, wie 0,5. - Für mathematisches Reasoning wird

temperature= 0,7 undtop-p= 1,0 empfohlen.

Beispielanfrage

Anwendungsfälle

Report-Generator

DeepSeek-R1 ist besonders geschickt in der Verarbeitung unstrukturierter Informationen und eignet sich daher ideal für die Analyse komplexer Dokumente wie Rechtsverträge, Finanzberichte oder wissenschaftliche Arbeiten. Reasoning-Modelle können die Mustererkennung erleichtern, indem sie mehrere Facetten der Informationen analysieren, bevor sie diese zu einer umfassenden Zusammenfassung destillieren. Beispiel-PromptEntwickle einen umfassenden Bericht über den Stand autonomer Fahrzeuge. Präsentiere diesen Bericht mit organisierten Abschnitten und einer kurzen Zusammenfassung. Achte darauf, die Errungenschaften mit der entsprechenden Entität zu zitieren, die diese Errungenschaft oder diesen Beitrag geleistet hat. Zum Kontext: Ich bin in diesem Bereich bewandert und habe ein technisches Verständnis von autonomen Fahrzeugsystemen. Ich habe den größten Teil meiner Karriere in der künstlichen Intelligenz gearbeitet, bin aber noch keinem Unternehmen beigetreten, das sich ausschließlich auf autonome Fahrzeuge konzentriert. Ich erwäge einen Karrierewechsel und möchte das aktuelle Ökosystem verstehen, bevor ich den Jobsuchprozess durchlaufe.

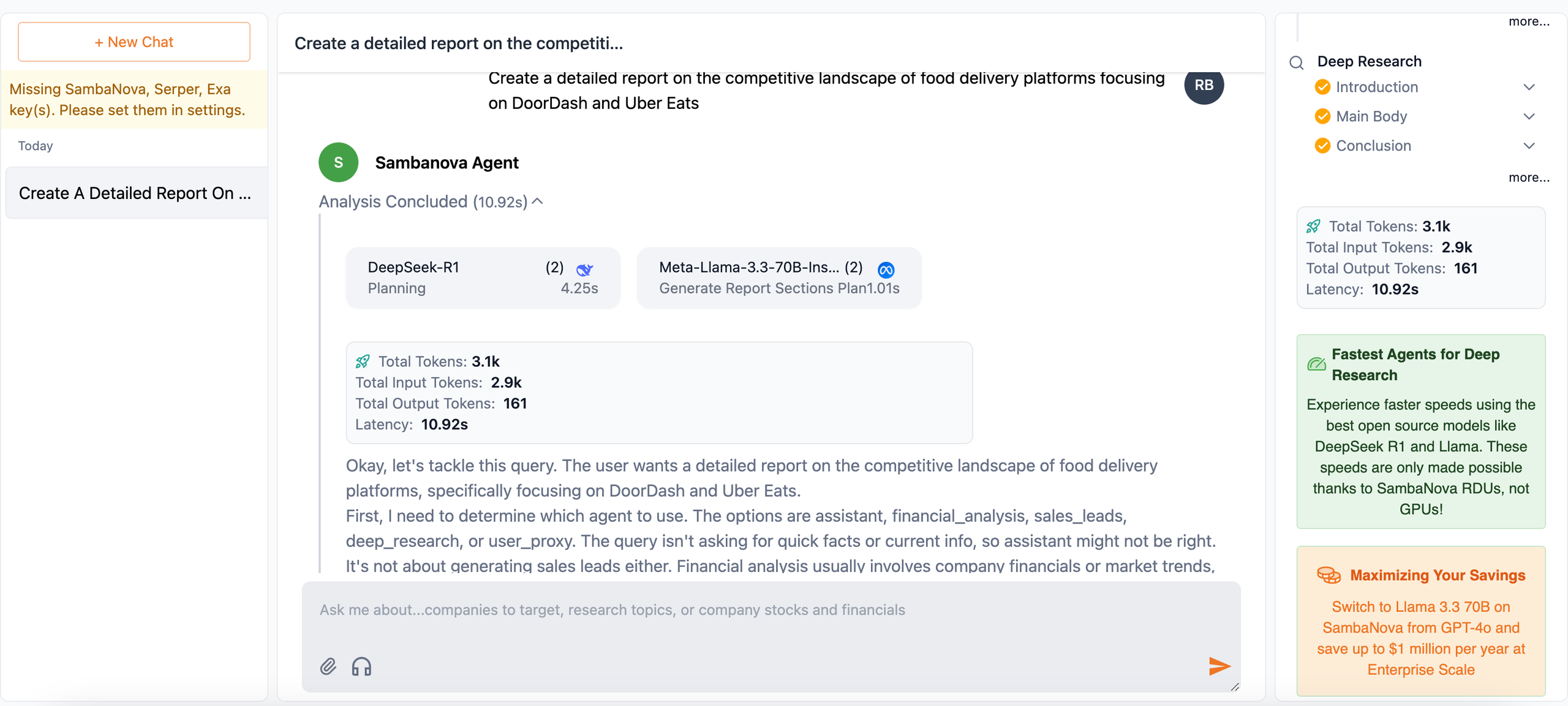

Planer für Workflows und Agents

Reasoning-Modelle zeichnen sich bei der Bewältigung mehrdeutiger und komplexer Aufgaben aus. Sie können komplizierte Probleme aufschlüsseln, Lösungen strategisch planen und Entscheidungen auf Grundlage großer Mengen mehrdeutiger Informationen treffen. Verwenden Sie DeepSeek-R1 als strategischen Planer für komplexe, mehrstufige Probleme. Es kann Aufgaben aufschlüsseln, detaillierte Lösungen entwickeln und sogar andere KI-Modelle für spezifische Teilaufgaben innerhalb eines agentischen Systems orchestrieren. Um die umfangreichen Fähigkeiten durchdachter Planung in einem leistungsstarken Workflow zu visualisieren, implementiert die Demo-App DeepSeek-R1 als Planer. Sie orchestriert Agents mit verschiedenen Workflows, wie Deep Research, Financial Analysis und Sales Leads. Die App ist Open Source und ermöglicht Entwicklern schnelles Experimentieren und einfache Produktion ihrer eigenen Agent-Workflows innerhalb des Systems.

Coding- und Mathematik-Guru

Diese Modelle sind effektiv bei der Überprüfung und Verbesserung von Code. Sie können kleinere Änderungen in einer Codebasis erkennen, die von menschlichen Reviewern übersehen werden könnten. Bei der Lösung mathematischer Probleme ist Reasoning hilfreich, um Aufgaben in viele Schritte aufzuschlüsseln und die Arbeit während des Lösens zu verifizieren.Best Practices

Latenz und Kosten

Latenz und Kosten

Reasoning-Modell-Outputs haben aufgrund ihres

<think>-Prozesses höhere Latenz und Token-Nutzung, daher sollten Sie erwägen, Nicht-Reasoning-Modelle für einfachere Aufgaben zu verwenden, um Budget- und Antwortzeit-Anforderungen zu optimieren. Die Funktionen haben Vorteile bei der ganzheitlicheren Betrachtung eines Benutzer-Prompts, nehmen aber auch Token-Kapazität und Zeit in Anspruch, um eine vollständige Antwort zu produzieren. Entwickler sollten das leistungsstarke Modell in optimalen Situationen für seinen Antwortansatz einsetzen.Streaming

Streaming

Die Aktivierung von Streaming kann die Benutzererfahrung in Anwendungen mit DeepSeek-R1 verbessern. Aufgrund des längeren Generierungsprozesses bestätigt diese Funktion und reduziert Mehrdeutigkeit und Erwartungshaltung, indem Tokens angezeigt werden, sobald sie verfügbar sind. Implementieren Sie dies, indem Sie den Parameter

stream=True in die Modellanfrage einfügen.Function Calling

Function Calling

Bei DeepSeek-R1 ist die aktuelle Implementierung von Function Calling instabil und führt gelegentlich zu Schleifen-Aufrufen oder leeren Antworten, wie in der DeepSeek-Dokumentation erwähnt. Prompt Engineering kann als Workaround durch Trial-and-Error implementiert werden, aber die Verwendung eines anderen Modells wäre optimal. Erfahren Sie mehr über Function Calling mit Modellen wie Llama-3.3-70B, indem Sie das Dokument Function Calling und JSON-Modus ansehen.

FAQs

Ich habe einen BadRequestError: 400 bezüglich der maximalen Kontextlänge von DeepSeek-R1 erhalten. Wo kann ich diese Information überprüfen?

Ich habe einen BadRequestError: 400 bezüglich der maximalen Kontextlänge von DeepSeek-R1 erhalten. Wo kann ich diese Information überprüfen?

Schauen Sie sich die Seite Infercom Cloud-Modelle für weitere Informationen zur aktuellen Kontextlänge des Modells an. Zögern Sie auch nicht, sich bei Fehlern in unserer Community zu melden.

Wenn das Modell von einem chinesischen Unternehmen erstellt wurde, wo wird es gehostet?

Wenn das Modell von einem chinesischen Unternehmen erstellt wurde, wo wird es gehostet?

Infercom hostet das Modell in europäischen Rechenzentren mit vollständiger EU-Datensouveränität.

Wie kann ich darauf zugreifen?

Wie kann ich darauf zugreifen?

Probieren Sie das Modell in unserem Playground aus und holen Sie sich dann einen API-Schlüssel, um Zugang zu erhalten.